|

Soy una investigadora en Google DeepMind y trabajo en manipulación robótica. Obtuve mi doctorado en el MIT trabajando con el Profesor Alberto Rodríguez. Desarrollo algoritmos y soluciones que permiten a los robots resolver nuevas tareas con gran precisión y destreza. Mi investigación fue financiada por las becas de LaCaixa y Facebook. {first_name}0bauza@gmail.com / CV / Bio / Google Scholar / LinkedIn |

|

|

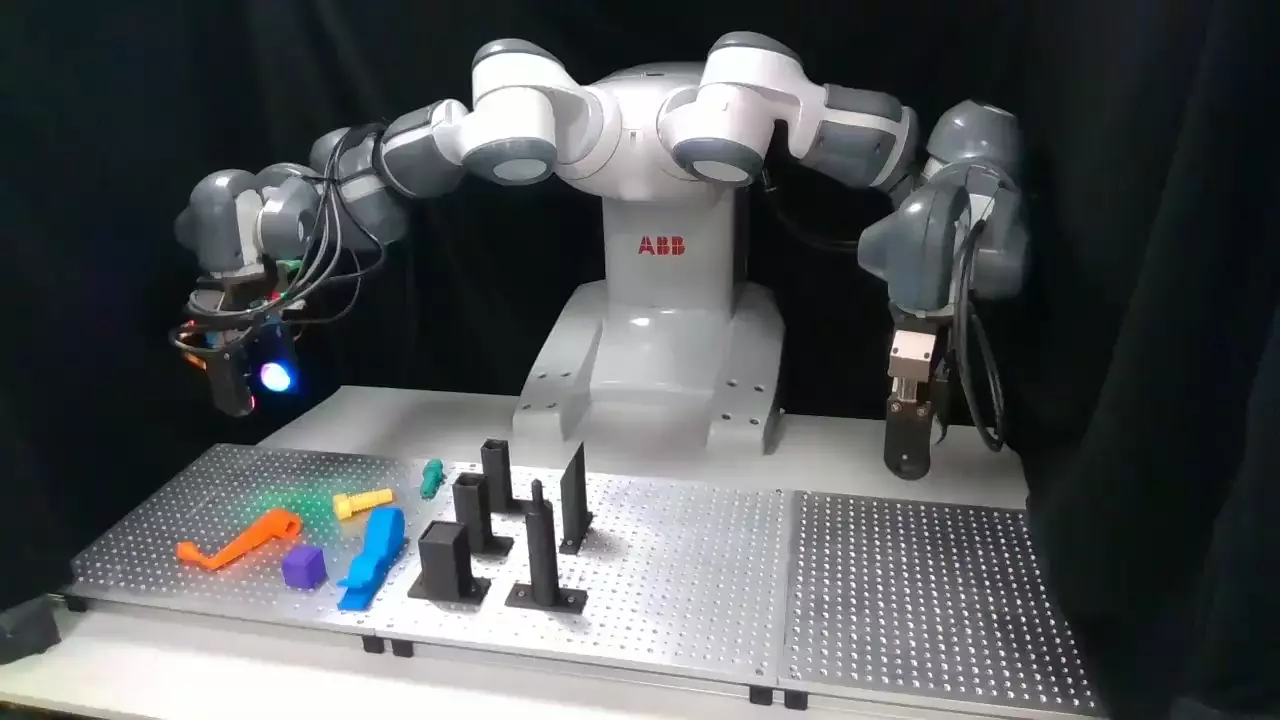

Mi investigación se centra en el desarrollo de algoritmos para la generalización robótica precisa: hacer que los robots sean capaces de resolver muchas tareas sin comprometer su rendimiento y fiabilidad. Al aprender modelos de percepción y control, podemos proporcionar a los robots las herramientas adecuadas para prosperar en situaciones y tareas variadas. En mi trabajo, he estudiado cómo el aprendizaje de modelos de IA permite un control preciso y cómo el desarrollo de una percepción de tacto y vision precisa permite resolver tareas complejas, como coger, localizar y colocar con precisión nuevos objetos sin experiencia previa. Mi objetivo es continuar desarrollando algoritmos que hagan que los robots sean diestros y versátiles al manipular su entorno. Proyecto final del doctorado: recogida y colocación precisa de objetos sin experiencia previa! ¿Porque es esto importante? Actualmente, la industria no puede resolver este problema para una gran variedad de objetos. Nuestro sistema abre la puerta a soluciones robóticas en una amplia variedad de aplicaciones donde la flexibilidad es clave. |

|

|

Diciembre 2025 Charla invitada en Deep Learning Barcelona Symposium (video). Octubre 2025 Charla invitada en LaCaixa Becarios Knowledge Day. Octubre 2025 Charla invitada en IROS Workshop Learning from Teleoperation. Octubre 2025 Charla invitada en IROS Workshop Tactile Sensing Toward Robot Dexterity and Intelligence. Junio 2025 Charla invitada en "A Robot Touch of AI: London Summer School in Robotics & AI 2025". Mayo 2025 Charla técnica en las Stage Presentations de ICRA. Mayo 2025 Charla invitada en el workshop de ICRA "Beyond Pick and Place". Mayo 2025 Charla invitada en el ciclo de conferencias "Cortex AI Research Talk Series" de Microsoft. Marzo 2025 Conferencia como profesora invitada en el MBA de la Oxford Saïd Business School. Noviembre 2024 Charla invitada en el workshop de CoRL "Learning Robotic Assembly". Octubre 2024 Charla invitada en DevFest Menorca. Agosto 2024 Charla invitada en el Forum Illa del Rei sobre IA. Junio 2024 Charla invitada en la clase de "Analytics and AI" de la Oxford Business School. Mayo 2024 Charla invitada en el Workshop Vitac de ICRA. Abril 2024 Charla invitada en el seminario de laboratorio de la ETH. Diciembre 2023 Charla invitada en el Deep Learning Barcelona Symposium. Diciembre 2023 Charla invitada y mesa redonda en el "Balearic Ecosystem for AI". Julio 2023 Profesor invitado en la clase de "Machine Learning for Business" del MBA de Oxford. Enero 2023 Entrevista como invitado en "Robot Talk", el pódcast de la UK Robotics and Autonomous Systems Network. Septiembre 2022 Charla invitada en el workshop de RSS 2022 "The Science of Bumping Into Things". Agosto 2022 Defensa tesis: Precepcion con vision y tacto para manipulation robotica de gran destreza(video). |

|

Z. Si, J. Chen, E. Karagozler, A. Bronars, J. Hutchinson, T. Lampe, N. Gileadi, T. Howell, S. Saliceti, L. Barczyk, I. Correa, T. Erez, M. Shridhar, M. Martins, K. Bousmalis, N. Heess, F. Nori, M. Bauza enviado a ICRA 2026 PDF / sitio web Presentamos ExoStart, un marco de aprendizaje general y escalable que aprovecha el poder de la destreza humana para el control de manos robóticas. En particular, obtenemos datos de alta calidad recopilando demostraciones directas utilizando un exoesqueleto de bajo coste. |

|

Gemini Team Informe Técnico PDF / sitio web Gemini 2.5 Pro es el modelo de Google DeepMind más capaz hasta la fecha, alcanzando un rendimiento de vanguardia en benchmarks de codificación y razonamiento de frontera. Gemini 2.5 Pro es también un modelo pensante que sobresale en la comprensión multimodal y es capaz de procesar hasta 3 horas de video. |

|

Gemini Robotics Team Informe Técnico PDF / sitio web Gemini Robotics es un modelo generalista avanzado de Visión-Lenguaje-Acción (VLA) capaz de controlar robots directamente. Gemini Robotics ejecuta movimientos suaves y reactivos para abordar una amplia gama de complejas tareas, siguiendo instrucciones de vocabulario diverso y abierto. |

|

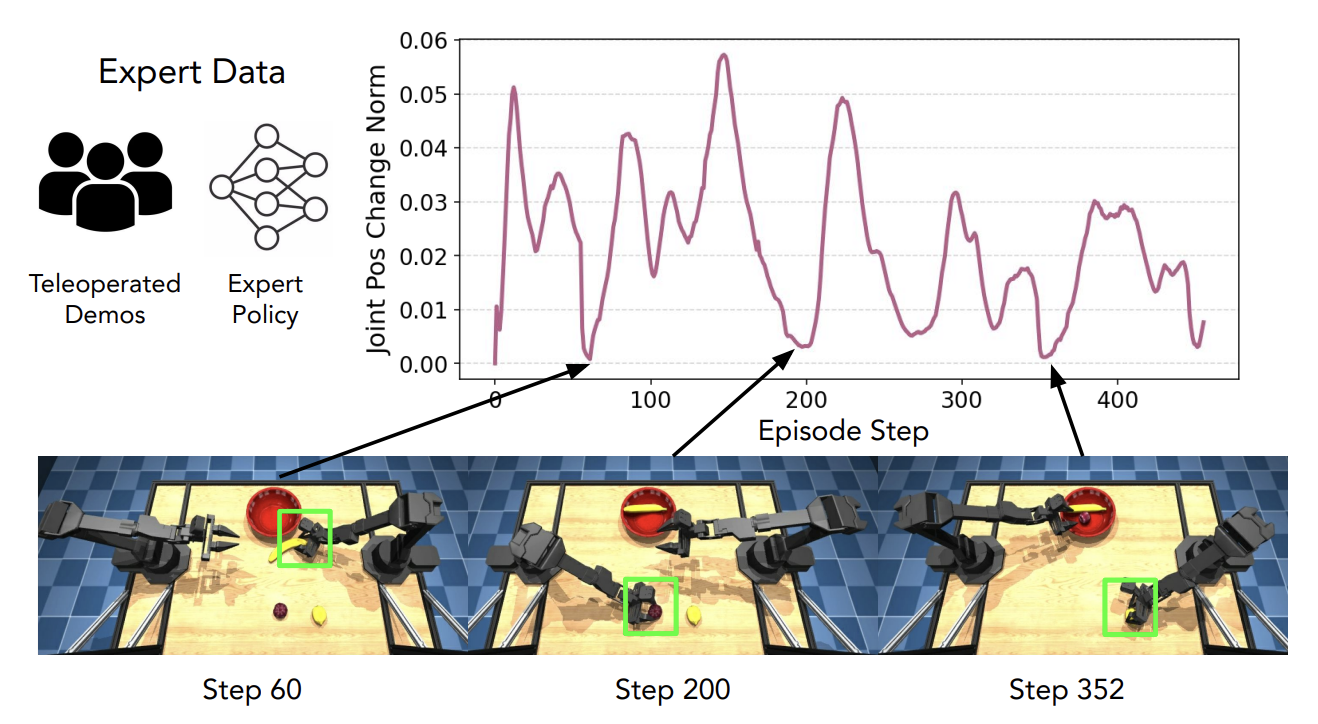

A. Chen, P. Brakel, A. Bronars, A. Xie, S. Huang, O. Groth, M. Bauza, et al. IROS , 2025 Investigamos cómo aprovechar la detectabilidad del comportamiento de inactividad para guiar la exploración y la mejora de la política. Nuestro enfoque, Perturbaciones Inducidas por Pausa (PIP), aplica perturbaciones en los estados de inactividad detectados, ayudando así a escapar del problema de inactivdad. |

|

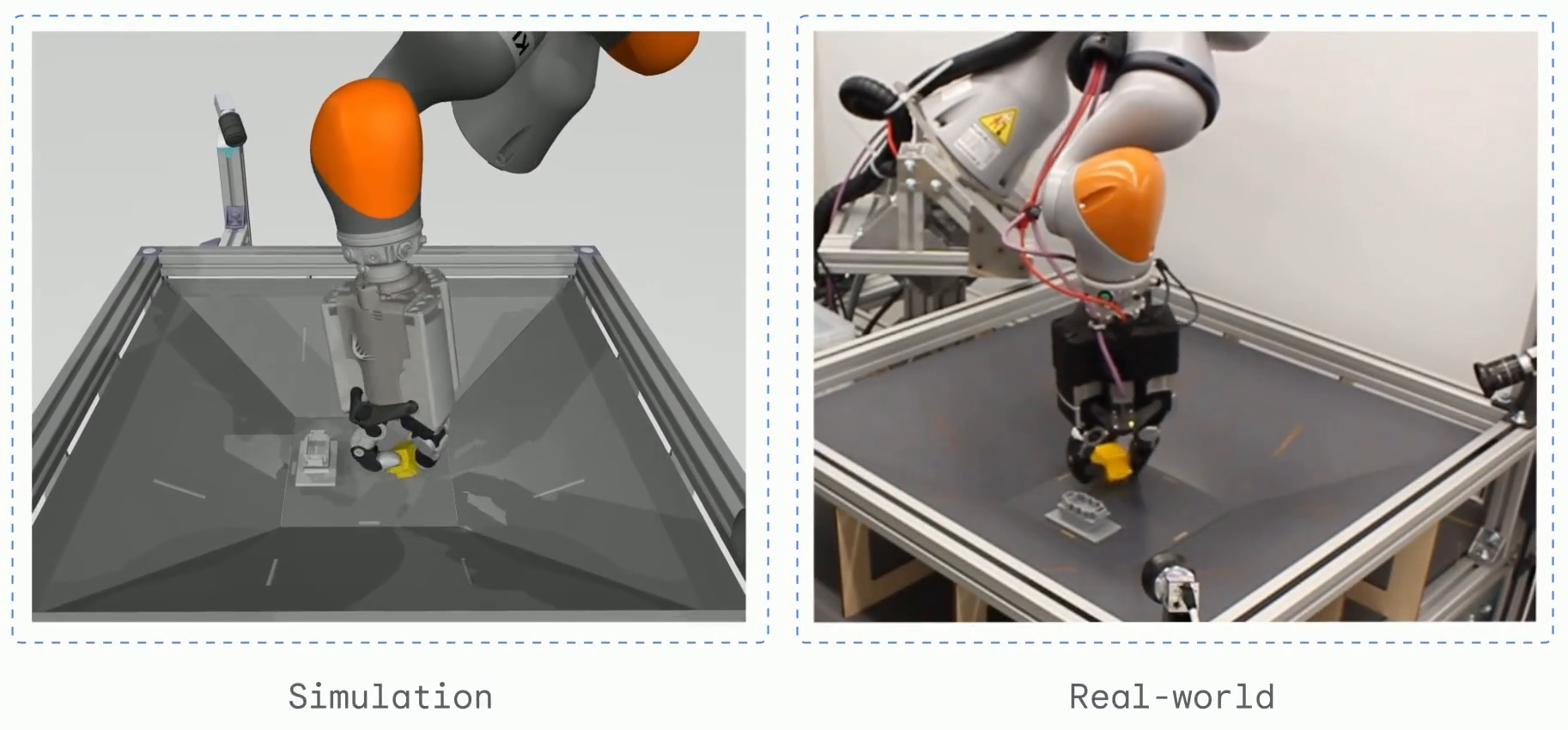

M. Bauza, J. Chen, V. Dalibard, N. Gileadi, et al. ICRA 2025 PDF / sitio web DemoStart es un método de aprendizaje por refuerzo con autocurrículo capaz de aprender comportamientos de manipulación complejos en un brazo equipado con una mano robótica de tres dedos, usando una recompensa dispersa y un puñado de demostraciones. |

|

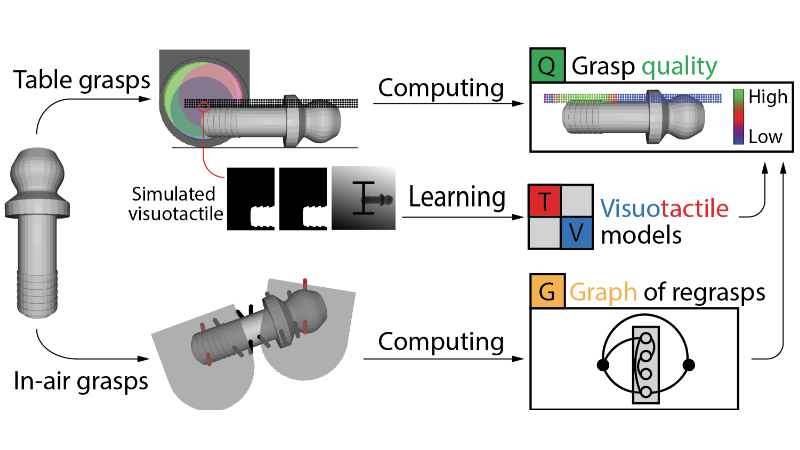

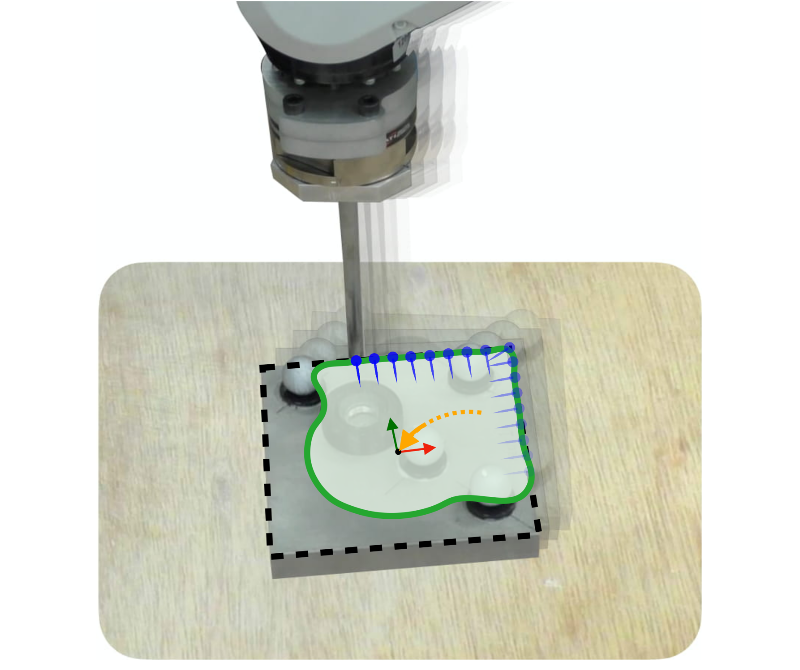

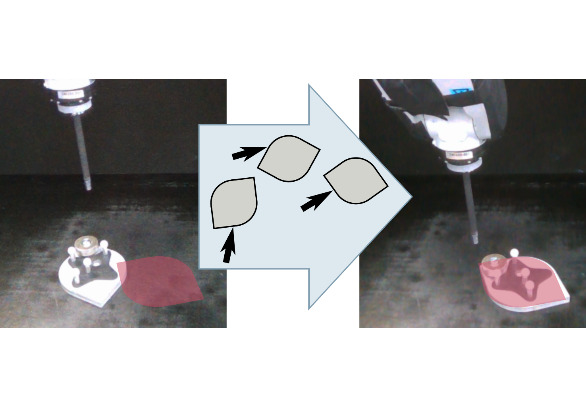

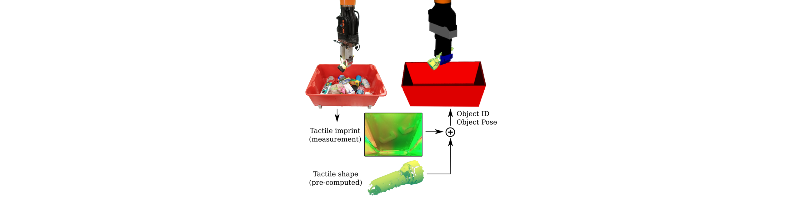

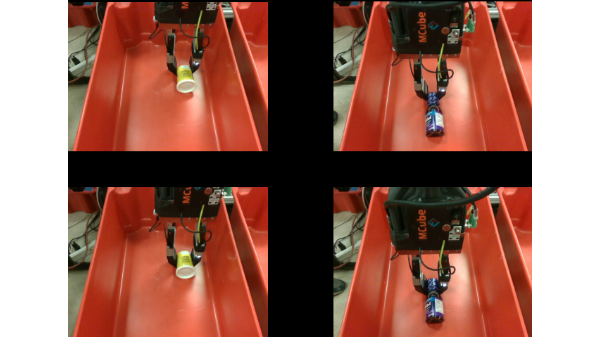

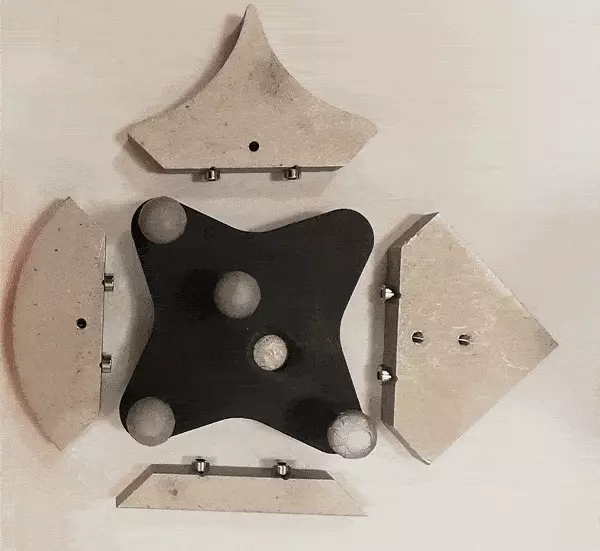

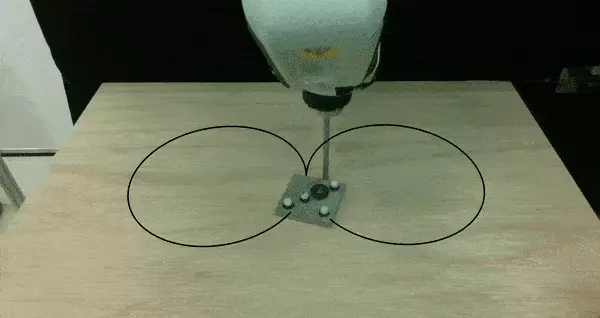

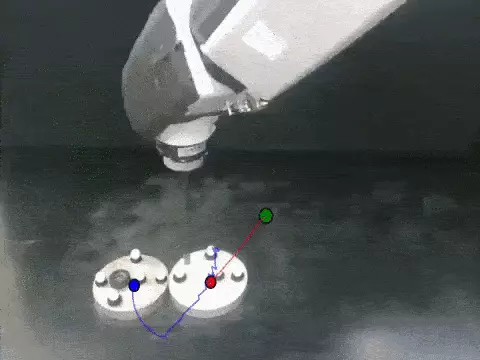

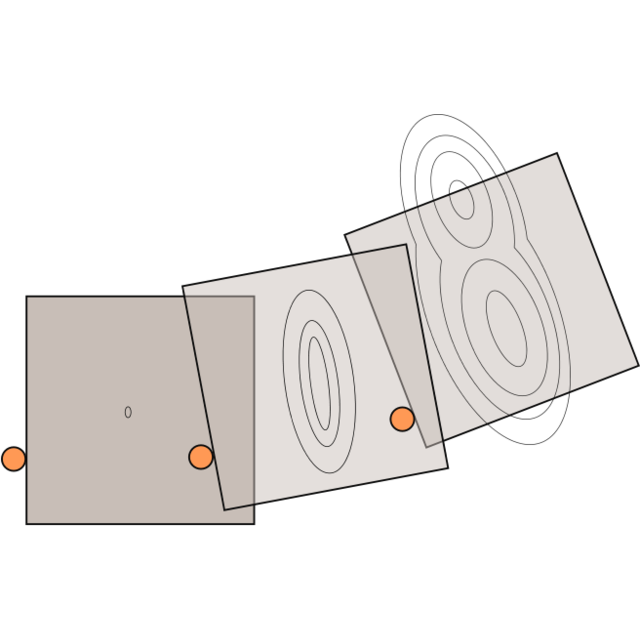

M. Bauza, T. Bronars, Y. Hou, I. Taylor, N. Chavan-Dafle, A. Rodriguez Science Robotics, 2024 PDF / sitio web Aprendemos en simulación cómo recoger y colocar objetos con precisión mediante percepción visuotáctil. Nuestra solución se transfiere al mundo real y maneja con éxito diferentes tipos de formas de objetos sin requerir experiencia previa. |

|

Jacky Liang, Fei Xia, Wenhao Yu, Andy Zeng, Montserrat Gonzalez Arenas, Maria Attarian, Maria Bauza, et al. RSS, 2024 PDF / sitio web Language Model Predictive Control (LMPC) es un marco que ajusta PaLM 2 para mejorar su capacidad de enseñanza en 78 tareas a través de 5 tipos de robots. LMPC acelera la adaptación rápida del robot mediante el aprendizaje en contexto. |

|

K. Bousmalis, G. Vezzani, D. Rao, C. Devin, A. Lee, M. Bauza, et al. TMLR, 2023 PDF / sitio web Presentamos RoboCat, un agente de IA para robótica que se automejora, aprende a realizar una variedad de tareas en diferentes brazos y luego genera nuevos datos de entrenamiento para mejorar su técnica. |

|

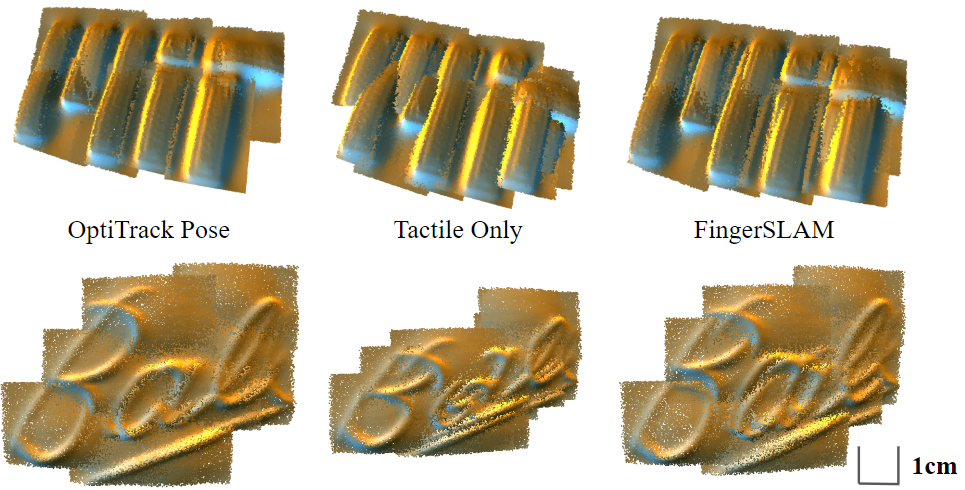

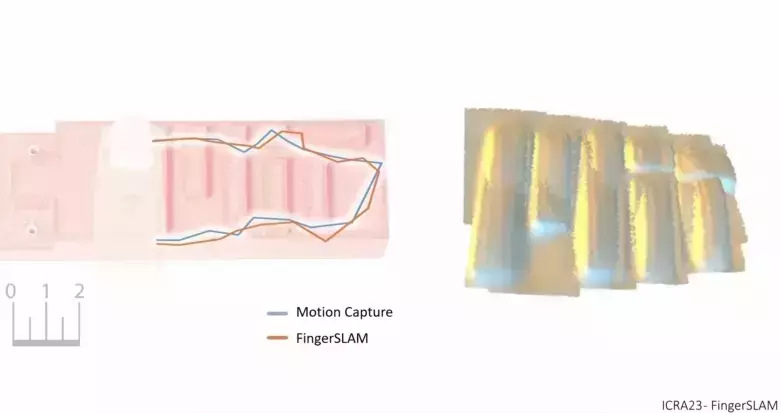

J. Zhao, M. Bauza, E. Adelson under review, 2022 Estudiamos el uso de la vision y el tacto para la localización con 6-GdL y la reconstrucción 3D de objetos desconocidos dentro de la mano. |

|

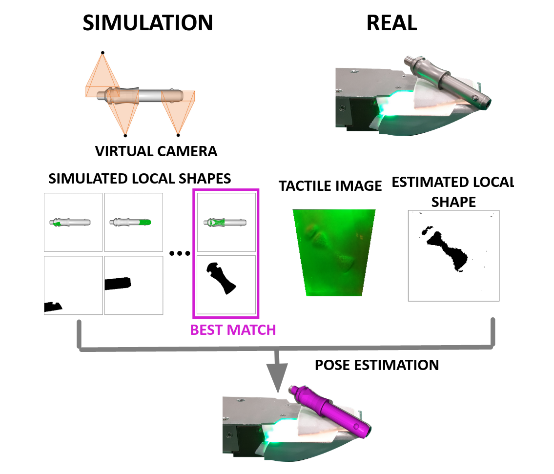

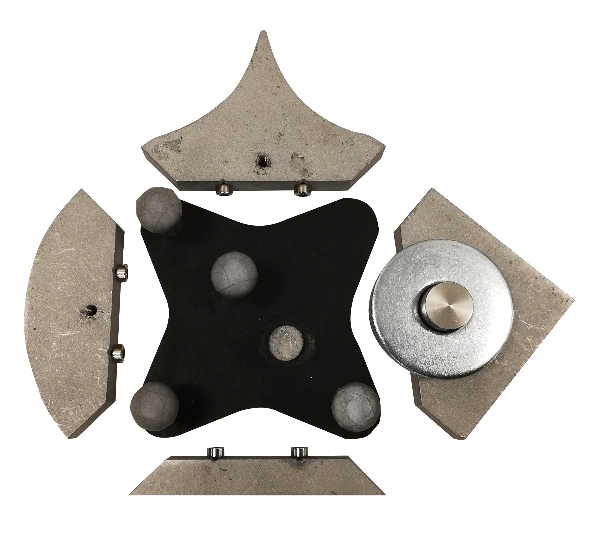

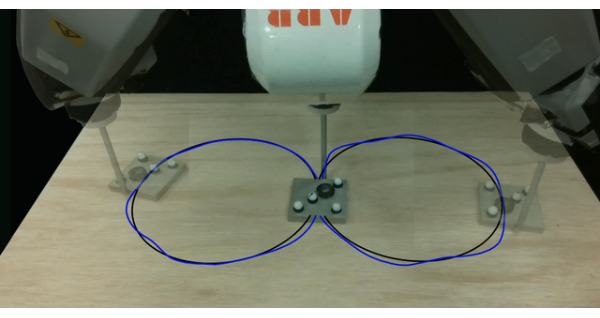

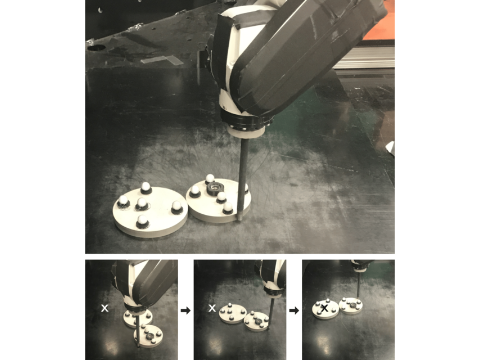

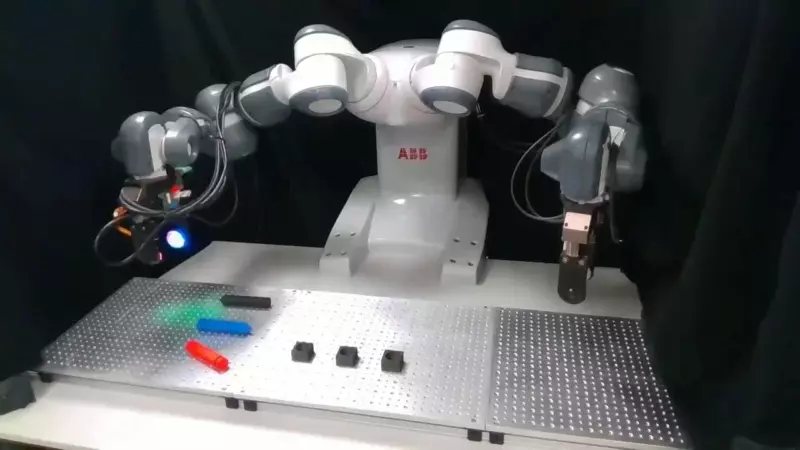

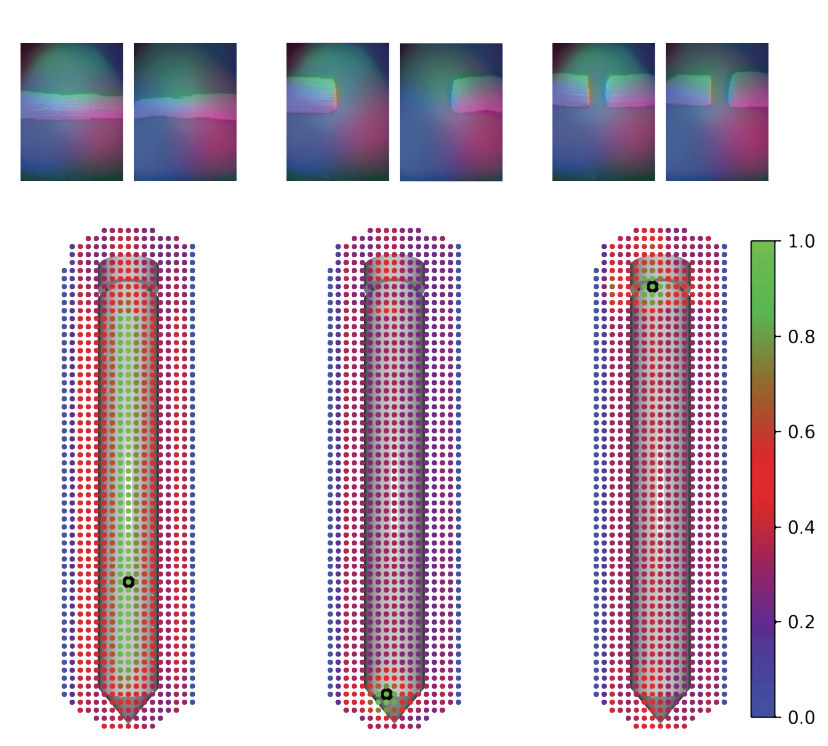

M. Bauza, T. Bronars, A. Rodriguez under review, 2022 Aprendemos en simulación cómo localizar objetos con precisión con el tacto. Nuestra solución transfiere al mundo real, brindando distribuciones de posición y orientación fiables desde el primer contacto. Nuestra tecnologia se usa en Magna, ABB y MERL. Nuestro sensor tactil es Gelslim. |

|

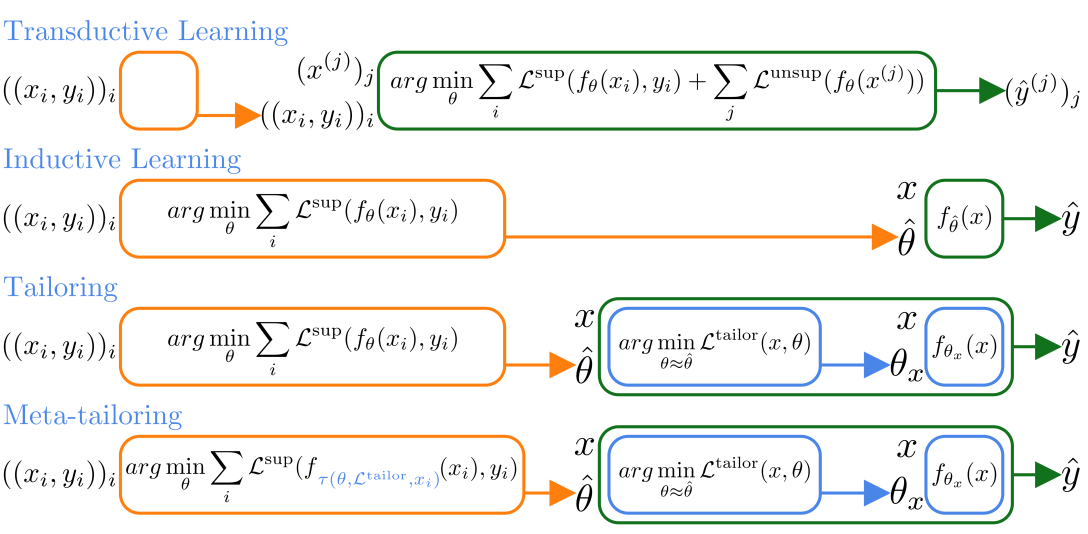

F. Alet, K. Kawaguchi, M. Bauza, N. Kuru, T. Lozano-Perez, L. Kaelbling NeurIPS, 2021 Creamos un modelo individual para cada punto, optimizando objetivos no supervisados. Asi evitamos brechas de generalización y podemos imponer una amplia variedad de estructuras. |

|

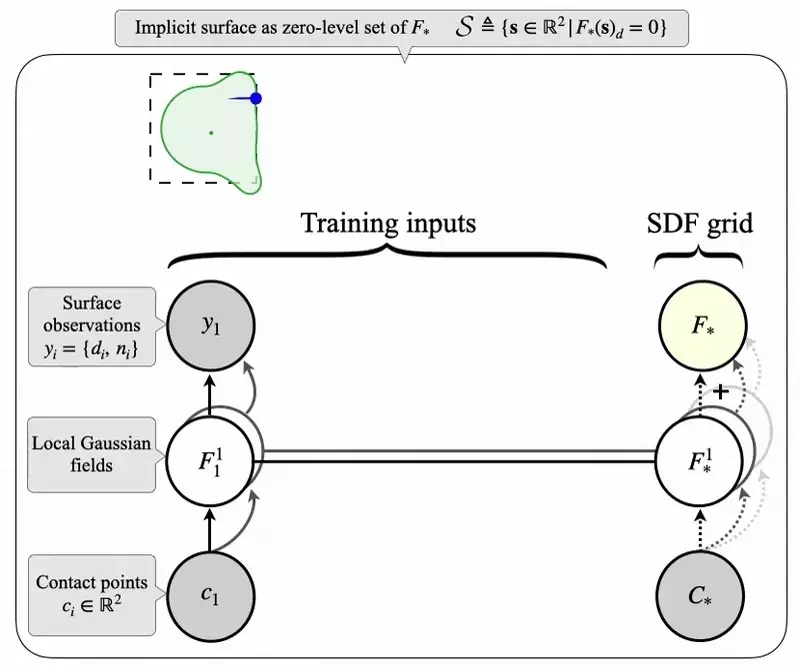

S. Suresh, M.Bauza, A. Rodriguez, J. Mangelson, M. Kaess ICRA, 2021 (Best Paper Finalist on the ICRA21 Service Robotics Award) PDF / video / codigo / sitio web En tiempo real, inferimos de los empujes planos tanto la forma como la pose de un objeto. |

|

M. Bauza, E. Valls, B. Lim, T. Sechopoulos CORL, 2020 PDF / video / sitio web |

|

A. Kloss, M. Bauza, J. Wu, J. Tenenbaum, A. Rodriguez, J. Bohg ICRA, 2020 PDF / video |

|

M. Bauza, O. Canal, A. Rodriguez ICRA, 2019 PDF / video / sitio web Reconstrucción de la forma y localización de objetos utilizando el sensor táctil basado en visión GelSlim. |

|

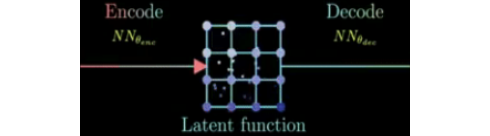

Y. Lin, M. Bauza, P. Isola CORL, 2019 PDF / codigo / sitio web Aprender a codificar nuevos objetos para generar predicciones de video físicamente plausibles. |

|

M. Bauza*, F. Hogan* , O. Canals, A. Rodriguez IROS, 2018 (Best Poster Award at ICRA 2018 workshop) PDF / video Reagarre usando un sensor táctil de alta resolución para mejorar la estabilidad de agarre. |

|

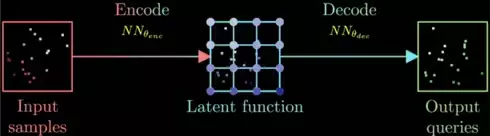

F. Alet, A. Jeewajee, M. Bauza, A. Rodriguez, T. Lozano-Perez, L. Kaelbling ICML, 2019 (Oral Presentation) PDF / video / sitio web Aprendemos a mapear de funciones a funciones mediante la combinación de redes neuronales en grafos y un mecanismo de atención. |

|

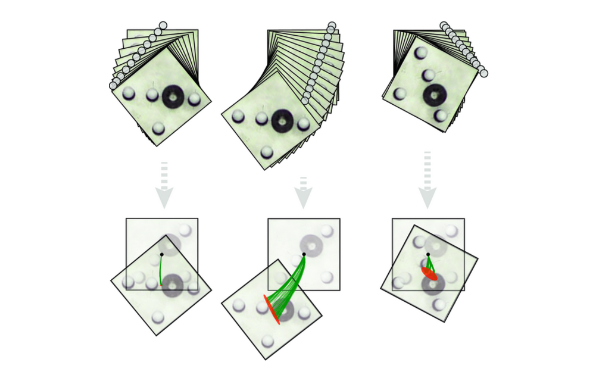

M. Bauza, F. Alet, Y. Lin, T. Lozano-Perez, L. Kaelbling, P. Isola, A. Rodriguez IROS, 2019 PDF / sitio web Presentamos un gran conjunto de datos de alta calidad sobre empujes plano que incluye video RGB-D y una amplia variabilidad de objetos. |

|

M. Bauza*, F. Hogan* , A. Rodriguez CORL, 2018 PDF / video Exploramos la complejidad de los datos necesarios para controlar, en lugar de modelar, el empuje plano. |

|

A. Ajay, M. Bauza, J. Wu, N. Fazeli, J. Tenenbaum, A. Rodriguez ICRA, 2019 PDF / sitio web Proponemos un modelo dinámico híbrido, redes de interacción aumentadas por simulador, que combina un simulador de física con una red neuronal basada en objetos. |

|

A. Ajay, J. Wu, N. Fazeli, M. Bauza, L. Kaelbling, J. Tenenbaum, A. Rodriguez IROS, 2018 (Best Paper Award on Cognitive Robotics) PDF / sitio web Aumentamos un simulador analítico de cuerpo rígido con una red neuronal que aprende a modelar la incertidumbre como residuos. Premio al mejor artículo sobre robótica cognitiva en IROS 2018. |

|

A Zeng, S Song, K. Yu, E. Donlon, F. Hogan, M. Bauza, et. al. ICRA, 2018 (Best Systems Paper Award by Amazon Robotics) PDF / video / sitio web Con el equipo de MIT-Princeton desarrollamos un sistema robótico robusto para reponer objetos. |

|

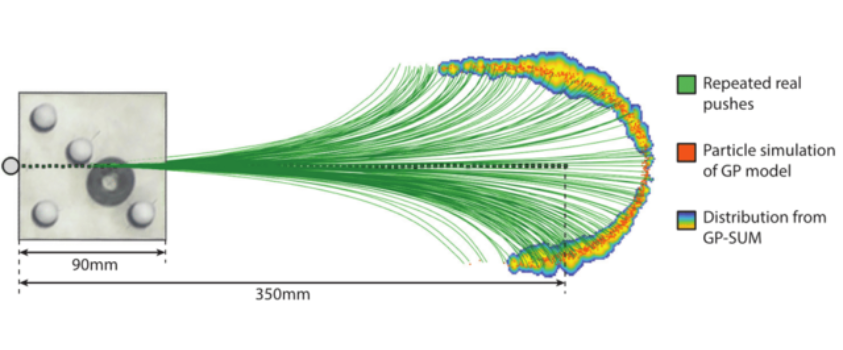

M. Bauza, A. Rodriguez WAFR, 2018 Desarrollamos el algoritmo GP-SUM: un filtro GP-Bayes que propaga en el tiempo incertidumbres no gaussianas. |

|

M. Bauza, A. Rodriguez ICRA, 2017 La caracterización de la incertidumbre de los diferentes empujes permite una mejor selección de acciones. |

|

K. Yu, M. Bauza, N. Fazeli, and A. Rodriguez IROS, 2016 (Finalista aMejor Articulo en IROS) PDF / video / sitio web Más de un millón de datos recopilados en experimentos de empuje reales. |

|

Julio 2022 Charla invitada en el workshop de RSS 2022 sobre la ciencia de golpearse con cosas (The Science of Bumping Into Things). Mayo 2022 Co-organizacion en ICRA 2022 del workshop de Manipulacion bimanual: como resolver los retos en el mundo real (Bi-manual Manipulation: Addressing Real-world Challenges). Marzo 2022 Charlas invitadas en EPFL, Princeton University, CMU y University of Pennsylvania. Febrero 2022 Charlas invitadas en Columbia University, the Autonomy Talks at ETH Zurich y Cornell Tech. Diciembre 2021 Charla invitada en Washington University robotics colloquium. Noviembre 2021 Charla invitada en Stanford y CMU Manipulation discussion grup. Octubre 2021 Charla invitada en Cornell Robotic Seminar y seleccionada para asistir a las estrellas en ascenso de EECS (Rising Stars in EECS). Julio 2021 Asisti al workshop de pioneros de RSS (2021 RSS Pioneers Workshop). Mayo 2021 Finalista para el premio de mejor articulo de robots de servicio en ICRA 2021 Marzo 2021 Charla invitada en el seminario de AI de la universidad de Toronto. Octubre 2020 Charla invitada en el seminario GRASP de University of Pennsylvania. Mayo 2020 Co-organizacion del workshop de ICRA 2020 sobre Incertidumbre en las interacciones con abundante contacto (Uncertainty in Contact-Rich Interactions). Noviembre 2019 Seleccionada para atender la cumbre mundial de jovenes cientificos (Global Young Scientists Summit). Otorgada solo a 5 estudiantes de doctorado entre todos los departamentos de MIT. Octubre 2019 Seleccionada como estrella en ascenso en ingenieria mecanica (Rising Stars in Mechanical Engineering). Otorgada a 30 estudiantes mujeres de doctorado y postdoctorado a nivel internacional. Enero 2019 Recibi la beca de Facebook para el doctorado (Facebook Emerging Scholar Award). Entregada a 21 de las 900 aplicaciones. Diciembre 2018 Recibi la beca de NVIDIA para el doctorado (NVIDIA Graduate Fellowship). Entregada a 10 de las mas de 30 aplicaciones. |

|

Gracias por compartir este diseño de sitio web. |